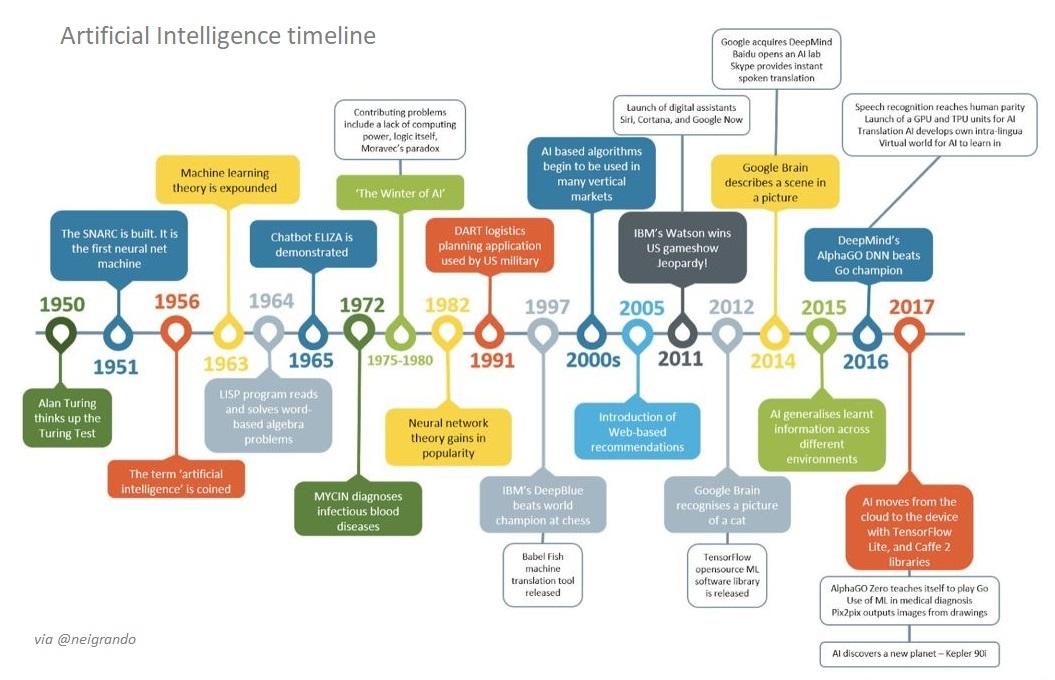

É incrível o que temos visto de avanço da Inteligência Artificial (IA) no nível de negócios em diversos setores da economia apoiando e acelerando soluções com aplicações em diversas funções ou áreas de negócio. Mas tudo isso só foi possível graças ao barateamento dos custos de infraestrutura e a dedicação dos cientistas em pesquisas de algoritmos que simulam a inteligência humana na resolução de diversos problemas que até há pouco tempo só podiam ser resolvidos por profissionais especialistas em suas respectivas áreas de atuação.

Neste post, compartilho uma linha do tempo das circunstâncias em que a IA atingiu ou superou o desempenho de nível humano. A lista descreve conquistas em jogos, diagnósticos médicos precisos e outras tarefas humanas gerais, mas sofisticadas, que a IA executou em um nível humano ou sobre-humano.

É importante não interpretar excessivamente esses resultados. As tarefas abaixo são altamente específicas e as realizações, embora impressionantes, nada dizem sobre a capacidade dos sistemas de generalizar para outras tarefas.

1980 - Otelo

Na década de 1980, Kai-Fu Lee e Sanjoy Mahajan desenvolveram o BILL, um sistema de aprendizagem bayesiano para jogar o jogo de tabuleiro Otelo. Em 1989, o programa ganhou o torneio nacional dos Estados Unidos de jogadores de computador e derrotou o jogador dos Estados Unidos mais bem classificado, Brian Rose, por 56-8. Em 1997, um programa chamado Logistello venceu todos os jogos em uma partida de seis jogos contra o atual campeão mundial Otelo.

1995 - Jogo de damas

Em 1952, Arthur Samuels construiu uma série de programas que jogavam damas e melhoravam por conta própria. No entanto, foi só em 1995 que um programa de jogo de damas, o Chinook, venceu o campeão mundial.

1997 - Xadrez

Alguns cientistas da computação na década de 1950 previram que um computador derrotaria o campeão de xadrez humano em 1967, mas foi só em 1997 que o sistema DeepBlue da IBM derrotou o campeão de xadrez Gary Kasparov. Hoje, os programas de xadrez executados em smartphones podem ser executados no nível de grande mestre.

2011 - Jeopardy!

Em 2011, o sistema de computador IBM Watson competiu no popular programa de testes Jeopardy! contra os ex-vencedores Brad Rutter e Ken Jennings. Watson ganhou o primeiro prêmio de $1 milhão.

2015 - Jogos Atari

Em 2015, uma equipe do Google DeepMind usou um sistema de aprendizado por reforço para aprender a jogar 49 jogos Atari. O sistema foi capaz de atingir um desempenho de nível humano na maioria dos jogos (por exemplo, Breakout), embora alguns ainda estejam significativamente fora de alcance (por exemplo, Montezuma’s Revenge).

2016 - Classificação de objetos em ImageNet

Em 2016, a taxa de erro da rotulagem automática do ImageNet diminuiu de 28% em 2010 para menos de 3%. O desempenho humano é de cerca de 5%.

2016 - GO

Em março de 2016, o sistema AlphaGo desenvolvido pela equipe Google DeepMind venceu Lee Sedol, um dos maiores jogadores de Go do mundo, por 4—1. DeepMind então lançou AlphaGo Master, que derrotou o jogador com melhor classificação, Ke Jie, em março de 2017. Em outubro de 2017, um artigo da Nature detalhou mais uma nova versão, AlphaGo Zero, que venceu o sistema AlphaGo original 100—0.

2017 - Classificação de câncer de pele

Em um artigo da Nature de 2017, Esteva et al. descrever um sistema de IA treinado em um conjunto de dados de 129.450 imagens clínicas de 2.032 doenças diferentes e comparar seu desempenho diagnóstico com o de 21 dermatologistas certificados. Eles descobriram que o sistema de IA é capaz de classificar o câncer de pele em um nível de competência comparável ao dos dermatologistas.

2017 - Reconhecimento de voz na mesa de controle

Em 2017, a Microsoft e a IBM alcançaram desempenho dentro da faixa próxima de reconhecimento de voz de “paridade humana” no domínio limitado do Switchboard.

2017 - Pôquer

Em janeiro de 2017, um programa da CMU chamado Libratus derrotou quatro jogadores humanos em um torneio de 120.000 jogos de dois jogadores, heads-up, no-limit Texas Hold’em. Em fevereiro de 2017, um programa da Universidade de Alberta chamado DeepStack jogou um grupo de 11 jogadores profissionais com mais de 3.000 jogos cada. DeepStack ganhou jogos de pôquer suficientes para provar a significância estatística de sua habilidade sobre os profissionais.

2017 - Pac-Man

Maluuba, uma equipe de aprendizado profundo adquirida pela Microsoft, criou um sistema de IA que aprendeu como atingir o valor máximo de pontos do jogo de 999.900 no Atari 2600.

2018 - Tradução Chinês-Inglês

Um sistema de tradução automática da Microsoft alcançou qualidade e precisão de nível humano ao traduzir notícias do chinês para o inglês. O teste foi realizado no newstest2017, um conjunto de dados comumente usado em competições de tradução automática.

2018 - Capturar a bandeira

Um agente da DeepMind alcançou desempenho de nível humano em uma versão modificada do Quake III Arena Capture the Flag (um popular videogame multiplayer 3D em primeira pessoa). Os agentes mostraram comportamentos semelhantes aos dos humanos, como navegar, seguir e defender. Os agentes treinados excederam a taxa de vitória de fortes jogadores humanos, tanto como companheiros de equipe quanto como adversários, derrotando vários sistemas de última geração existentes.

2018 - DOTA 2

OpenAI Five, a equipe de cinco redes neurais da OpenAI, derrota equipes humanas amadoras no Dota 2 (com restrições). O OpenAI Five foi treinado jogando 180 anos de jogos contra si mesmo todos os dias, aprendendo por meio do jogo sozinho. (OpenAI Five ainda não é sobre-humano, pois não conseguiu vencer uma equipe humana profissional).

2018 - Classificação do câncer de próstata

O Google desenvolveu um sistema de aprendizado profundo que pode atingir uma precisão geral de 70% ao avaliar o câncer de próstata em espécimes de prostatectomia. A precisão média alcançada por patologistas gerais certificados pelos EUA no estudo foi de 61%. Além disso, de 10 patologistas gerais individuais de alto desempenho que classificaram todas as amostras no conjunto de validação, o sistema de aprendizado profundo foi mais preciso do que 8.

2018 - Alphafold

A DeepMind desenvolveu o Alphafold que usa uma grande quantidade de dados de sequência geométrica para prever a estrutura 3D da proteína com um nível de precisão incomparável do que antes.

2019 - Alphastar

DeepMind desenvolveu Alphastar para derrotar um jogador profissional de topo em Starcraft II.

2019 - Detectar retinopatia diabética (RD) com precisão de nível especializado

Um estudo recente mostra uma das maiores validações clínicas de um algoritmo de aprendizado profundo com uma precisão significativamente maior do que os especialistas. A compensação pela redução da taxa de falsos negativos são taxas de falsos positivos ligeiramente maiores com a abordagem de aprendizado profundo.

fonte: Stanford AI Index Report 2019

Um abraço, @neigrando

Alguns artigos relacionados com a Inteligência Artificial nos Negócios

- Como é a Tomada de Decisão orientada pela IA

- Delegação da Decisão: Humana e, ou, IA

- Blocos de Construção da Inteligência Artificial

- Os 7 Padrões da Inteligência Artificial

- As 4 ondas da inteligência artificial

- Introdução à computação cognitiva

- Racionalidade Limitada e Vieses Cognitivos

- Por uma sociedade melhor, quem sabe 5.0

- Brasil Rumo à Indústria 4.0

- Transformação Digital – Por que, o que, e como fazer

- Decisão e processo decisório

- Como lidar com as incertezas dos negócios